KI-Anwendungsszenario

Autonomes Fahrzeug als Waffe

Drohnenangriff auf Fußballstadion

Unzulässige Leistungskontrolle

Szenario 1: Angriff auf ein autonom fahrendes Fahrzeug

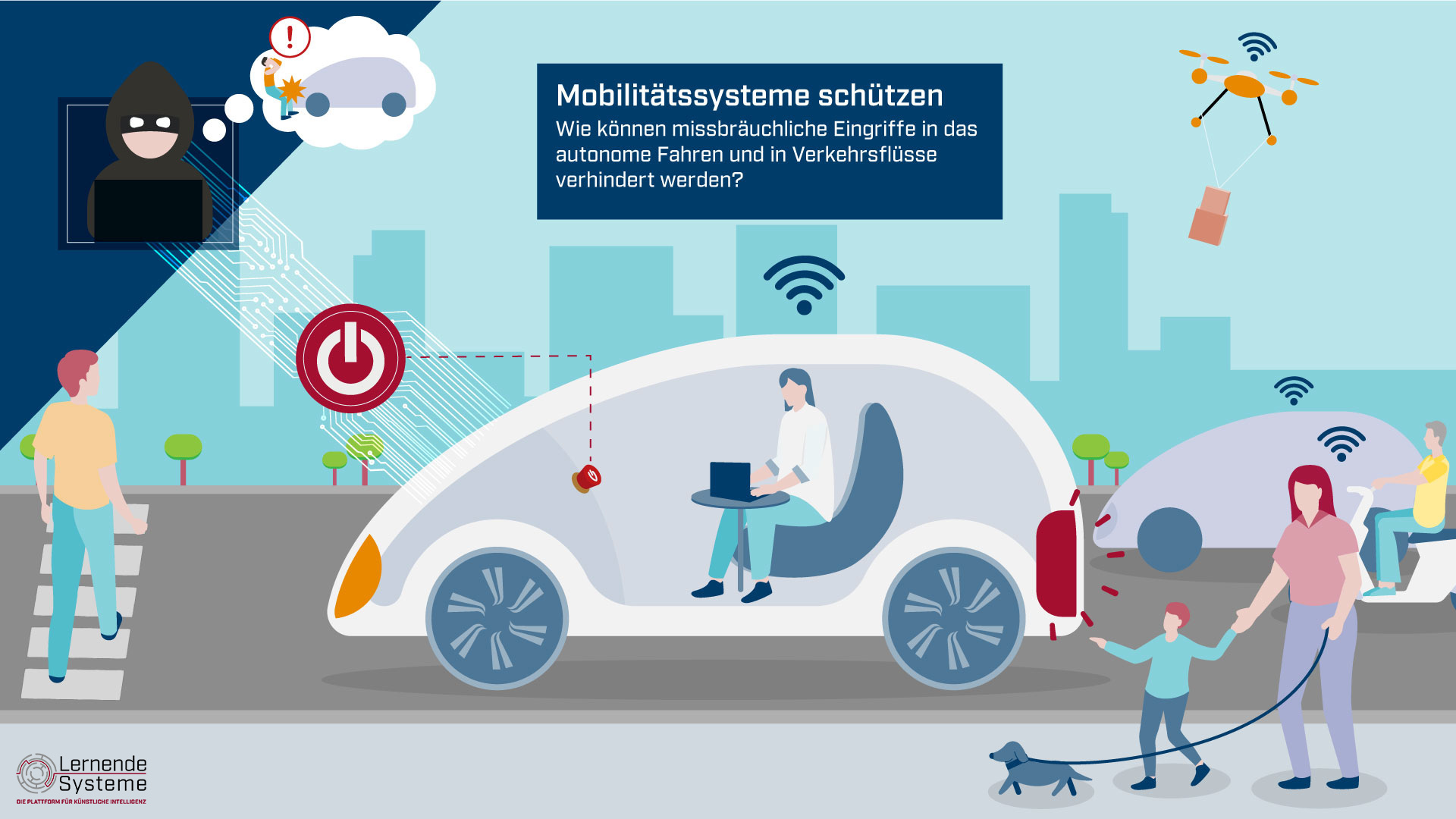

Im Straßenverkehr der Zukunft sind zahlreiche Fahrzeuge autonom unterwegs – als Pkw oder im öffentlichen Nahverkehr. Diese Fahrzeuge sind in sehr komplexe Mobilitätssysteme eingebettet, in denen sie mit der Verkehrsinfrastruktur kommunizieren. Dies ermöglicht ihnen, Sensor- und Verkehrsinformationen zu verarbeiten sowie während der Fahrten laufend dazu zu lernen. Das vernetzte Mobilitätssystem stellt hohe Anforderungen an die Funktionssicherheit von Hard- und Software sowie die Sicherheit vor Cyberangriffen. Zugleich muss eine Balance zwischen individueller Freiheit und erforderlicher Kontrolle gewahrt werden.

Wie sich verhindern lässt, dass böswillige Angreifer ein autonomes Fahrzeug manipulieren, um Schaden anzurichten, zeigt sich per Klick auf die Grafik.

Mit der Frage, welche Maßnahmen geeignet sind, um einem Missbrauch von KI-Systemen wirksam vorzubeugen, beschäftigt sich auch das Whitepaper KI-Systeme schützen, Missbrauch verhindern der Arbeitsgruppe IT-Sicherheit, Privacy, Recht und Ethik.

Szenario 2: Manipulation von Flugdrohnen bei einer Großveranstaltung

In schwer zugänglichen, gefährlichen oder komplexen Umgebungen können KI-Systeme Routineaufgaben übernehmen. Sie erkunden Gebiete, überwachen Infrastrukturen oder unterstützen die Kommunikation der Fachkräfte. Damit diese KI-Systeme – etwa beim Untersuchen oder Reparieren von Infrastrukturen – möglichst selbständig agieren können, werden sie mit speziellen Fähigkeiten ausgestattet; sie agieren (teil-)autonom. Eingesetzt werden sie sowohl als Einzelsysteme als auch in Interaktion miteinander, etwa als Flugdrohnen in einem Schwarm.

Flugdrohnen können künftig genutzt werden, um die Sicherheit bei Großveranstaltungen zu gewährleisten. Die integrierten Sensoren erfassen wichtige Informationen und leiten diese weiter. Da der Luftraum kaum über effiziente Abwehrsysteme oder mechanische Schutzvorrichtungen verfügt, lassen sich Flugdrohnen jedoch auch für gezielte Angriffe auf Personen, kritische Bereiche oder Objekte missbrauchen. Unser Szenario skizziert das Finale der Fußball-Weltmeisterschaft in einer Großstadt. Die Veranstalter lassen das Stadion mithilfe eines Schwarms KI-basierter Flugdrohnen aus der Luft überwachen. Diese kommunizieren untereinander und kooperieren bei Bedarf.

Wie sich verhindern lässt, dass böswillige Angreifer die Flugdrohnen manipulieren und Schaden anrichten, zeigt sich per Klick auf die Grafik.

Mit der Frage, welche Maßnahmen geeignet sind, um einem Missbrauch von KI-Systemen wirksam vorzubeugen, beschäftigt sich auch das Whitepaper KI-Systeme schützen, Missbrauch verhindern der Arbeitsgruppe IT-Sicherheit, Privacy, Recht und Ethik.

Szenario 3: Unzulässige Leistungskontrolle von Beschäftigten

KI-Systeme können bei mühsamen oder sich wiederholenden Tätigkeiten entlasten und Arbeitskräften helfen, Fehler zu vermeiden. Durch die laufende Erhebung und Analyse von Daten aus dem Arbeitsprozess passen sich die Systeme in der Zusammenarbeit den Beschäftigten und ihren Routinen an. So erfassen selbstlernende Roboterwerkzeuge in der Produktion künftig Schrittfolgen und Arbeitstechniken der Facharbeiterinnen und -arbeiter und können ihnen zum geeigneten Zeitpunkt assistieren. Indem sie auch physische Parameter wie Stresslevel, Müdigkeit oder Konzentration der Beschäftigten verarbeiten, optimieren KI-Systeme die Zusammenarbeit weiter und können Hinweise auf Über- oder Unterforderung geben. Auf einer aggregierten Ebene lassen sich so die individuelle Arbeitszufriedenheit sowie die Effizienz des Unternehmens steigern.

Allerdings können KI-Systeme auch zur Leistungskontrolle von Beschäftigten missbraucht werden. Wie sich das verhindern lässt, skizziert das folgende Beispiel eines Betriebs, der selbstlernende und miteinander vernetzte Roboterwerkzeuge in der Produktion einsetzt.

Mit der Frage, welche Maßnahmen geeignet sind, um einem Missbrauch von KI-Systemen wirksam vorzubeugen, beschäftigt sich auch das Whitepaper KI-Systeme schützen, Missbrauch verhindern der Arbeitsgruppe IT-Sicherheit, Privacy, Recht und Ethik.